Derzeit lese ich das Buch „I am a strange loop“ von Douglas Hofstadter, in dem er der Frage nachgeht, wie Bewusstsein entsteht und was dieses „ich“ eigentlich ist, von dem wir alle reden. Und da bin ich gestern auf Seite 90 über die folgende Passage gestolpert:

„(…) most of us wind up emerging from adolescence with a deeply nuanced sense of what is real, with shades of gray all over the place. (However, I have known, and probably you have too, reader, a few adults for whom every issue that strikes me as subtle seems to them totally black-and-white – no messy shades of gray at all to deal with. That must make life easy!“)

D. Hofstadter: I am a Strange Loop. Basic Books, 2007

Was in mir spontan eine ganze Flut von Assoziationen ausgelöst hat, beginnend mit der Beobachtung, dass ich nicht nur einige wenige, sondern eigentlich sogar sehr viele Leute kenne, die sich ihrer Sache immer sehr sicher sind, und nur sehr wenige, die zugeben würden, dass Dinge kompliziert sind oder gar, dass sie zu wenig davon verstehen, um sich ein abschließendes Urteil erlauben zu können. Ein Teil des Problems dabei ist, dass die Graustufen-Leute sich in Diskussionen typischerweise zurückhalten, während die Schwarz-Weiß-Leute ihre Überzeugungen lautstark und voller Inbrunst vertreten.

Die Auswirkungen davon habe ich bereits im Beitrag „The Middle Ground“ vom Mai 2021 diskutiert, ich will das Thema hier aber nochmal aufgreifen und aufzeigen, warum absolute Gewissheit meiner Meinung nach kein gutes Zeichen ist.

Philosophie des Geistes

Die Frage „Was kann ich wissen?“ gehört ja zu den vier Hauptfragen Kants und ist vor und nach ihm ausgiebig diskutiert worden. Sokrates‘ „Ich weiß, dass ich nichts weiß“ gehört ebenso in diese Diskussion wie Descartes‘ „Ich denke, also bin ich“. Und auch der Konstruktivismus, aus dem letztlich die derzeitigen Gender- und Wokeness-Debatten hervorgegangen sind, hat in dieser Frage seinen Ursprung.

Ohne hier tiefer in diese (ausgesprochen komplexe) Diskussion einsteigen zu wollen, zeigt allein die Tatsache, wie intensiv die Frage nach Wissen, Wahrheit und Erkenntnis jahrhundertelang diskutiert worden ist, dass einfache Antworten hier wohl nicht zu haben sind. Trotzdem trifft man auch hier (ausgerechnet!) auffallend viele Diskussionsteilnehmer, die sich im Alleinbesitz der Wahrheit wähnen.

Ich selbst staune immer wieder, wie man sich in solch komplexen Themen und bei solch intelligenten Personen auf allen Seiten des Meinungsspektrums so sicher sein kann, selbst im Alleinbesitz der Wahrheit zu sein. Ganz besonders wundert mich das aber bei diejenigen, deren philosophisches Fundament auf dem Konstruktivismus fußt. Denn wie kann man einerseits postulieren, dass eine objektive Erkenntnis der Wahrheit nicht möglich ist, zugleich aber überzeugt sein, dass die eigene Überzeugung die einzig richtige ist?

Bayes’sche Wahrscheinlichkeit

Die Idee der Bayes’schen Wahrscheinlichkeit formalisiert im Grunde genau das, was Hofstadter oben informal beschreibt: Unser Gehirn arbeitet gar nicht wirklich mit absoluten Überzeugungen, sondern mit subjektiven Wahrscheinlichkeiten, die sukzessive an neue Beobachtungen angepasst werden. Auf den ersten Blick müsste das dazu führen, dass unsere mentalen Modelle immer besser zur Wirklichkeit passen. Nur ist das nach meiner Beobachtung gar nicht das, was in Wahrheit passiert – vielmehr driften Überzeugungen häufig auseinander und neigen sogar dazu, in Extremen zu enden. Im Folgenden will ich einmal (ganz ohne echten wissenschaftlichen Anspruch, eher im Sinne eines Brainstormings) darüber nachdenken, woran das liegen könnte.

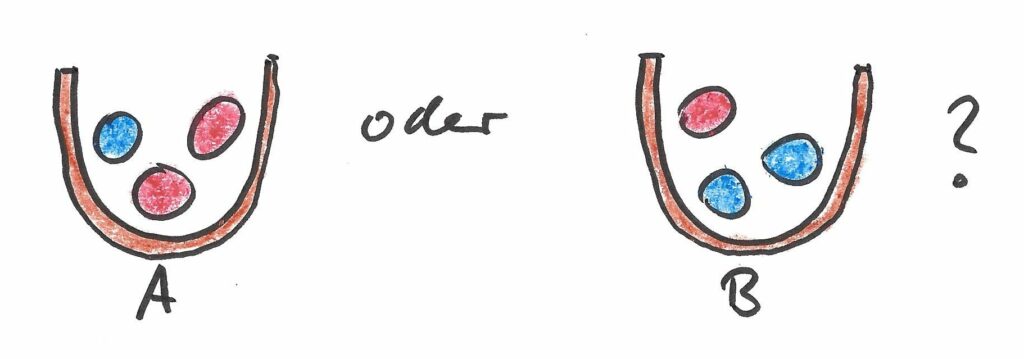

Ein erster, noch sehr ins Unreine gedachter Gedanke bezieht sich darauf, wie wir lernen. Bekanntlich hängt unser Wissen entscheidend davon ab, wie Neuronen in unserem Gehirn miteinander verbunden sind. Die verschiedenen Wahrscheinlichkeiten, von denen man in der Bayes’schen Statistik ausgeht, entsprechen in gewissem Sinne der Stärke der Verknüpfungen in unserem Gehirn. Wenn wir nun aber regelmäßig über ein Thema nachdenken, werden die Verbindungen, die besonders häufig verwendet werden (die mit den größten a-priori-Wahrscheinlichkeiten), verstärkt – sie sind in Zukunft noch leichter verfügbar und entsprechen somit noch größeren künftigen Wahrscheinlichkeiten. Ein anfänglicher leichter Vorteil für eine bestimmte Ansicht könnte sich daher mit der Zeit selbst verstärken, bis er zu einer echten Überzeugung geworden ist.

Nun ist das Nachdenken im stillen Kämmerlein ja nicht die einzige Möglichkeit, zu lernen: häufig spielt ja auch Input von außen eine Rolle (bei den Bayes’schen Modellen, die ich bisher gesehen habe, wird es sogar fest vorausgesetzt). Hier aber kommt unsere Neigung ins Spiel, kognitive Dissonanzen vermeiden zu wollen. Es ist uns nämlich eigentlich unangenehm, unsicher zu sein und unsere Überzeugungen immer wieder in Frage gestellt zu sehen. Daher neigen wir dazu, vor allem solches Input zu suchen, das zu unseren bereits gefassten Überzeugungen passt: wir umgeben uns bevorzugt mit Menschen, die unserer Meinung sind, bewegen uns im Netz in (selbstgewählten oder von sozialen Netzwerken erzeugten) Filterblasen und lesen bevorzugt Texte von Autoren, deren Auffassungen wir teilen. Auch interpretieren wir unliebsame Beobachtungen gerne um und suchen sogleich Gründe, warum sie gar kein wirkliches Problem für unsere vorgefasste Überzeugung sind. Auf diese Weise führt die wiederholte Beschäftigung mit einer Thematik gar nicht dazu, dass sich die Wahrscheinlichkeiten in unserem Kopf besser an die Realität annähern – vielmehr verstärkt eine solche Beschäftigung mit dem Thema lediglich die Gewissheit, von Anfang an richtig gelegen zu haben.

Beispiel: Was wir wissen können

Nehmen wir einmal die Frage, was wir wissen können, als Beispiel. Wenn ich eine ernsthafte Antwort auf diese Frage suche, muss ich mich mit den Argumenten des Empirismus, des Rationalismus und des Skeptizismus auseinandersetzen. Ich sollte die verschiedenen Herangehensweisen von Wissenschaft, Kunst, Religion und Philosophie zu dem Thema verstanden und einer fairen, vorurteilsfreien Würdigung unterzogen haben. Ich sollte zudem auf dem neuesten Stand der Kognitionspsychologie sein und mir im Klaren darüber sein, was wir über die Funktionsweise des menschlichen Gehirns sowie seiner technischen Nachahmungen wissen. Und ja: dieses Verständnis schließt auch die zugehörigen mathematischen und algorithmischen Modelle mit ein. Sogar der Erkenntnisstand der Physik (die zu kennen den Philosophen früherer Jahrhunderte eine Selbstverständlichkeit war) und der Mathematik (wie etwa Gödels Unvollständigkeitssatz) beeinflussen diese Diskussion.

Ich denke, es wird schon aus dieser Auflistung klar, warum eine solche Fragestellung höchst komplex ist. Menschen mit einer realistischen Selbsteinschätzung werden vermutlich zugeben, dass sie nicht all diese Themenfelder in der erforderlichen Tiefe beherrschen und dass ihre Überzeugungen daher unter einer Reihe von Vorbehalten stehen müssten.

Wenn wir das tatsächlich täten und aufrichtig versuchen würden, unsere Wissenslücken zu schließen, dann würde auch das Bayes’sche Modell des Erkenntnisgewinns wieder funktionieren. Derjenige aber, der umfassende, anstrengende und manchmal auch frustrierende Recherche gerne mal durch einfache, dafür aber umso leidenschaftlicher vorgetragene Standpunkte ersetzt, befindet sich einfach nur in einem selbstverstärkenden Feedback-Loop, der ihm zwar ein gutes Bauchgefühl (und tolle Klick-Zahlen in den sozialen Medien) verschafft, ihn aber der Wahrheit nicht wirklich näher bringt. Ja, es besteht sogar die Gefahr, dass seine Gewissheit nichts anderes ist als eine Variante des Dunning-Kruger-Effekts: es ist umso leichter, sich für kompetent zu halten, wenn weniger tief man in die wahre Komplexität des Themas eingetaucht ist.

Schlussbemerkung

Vielleicht wird nach dieser Diskussion klarer, warum mich ein solch ungutes Gefühl beschleicht, wenn jemand bei Themen wie Kapitalismus, Corona, Klimawandel, Gender, künstliche Intelligenz, freier Wille etc. allzu überzeugt von seiner (womöglich noch: einfachen) Wahrheit ist. Manchmal sind die Dinge einfach komplex, und es macht mich misstrauisch, wenn jemand in einer Welt voll intelligenter Menschen glaubt, sie besser als die anderen verstanden zu haben. Vielmehr vermute ich, dass der wahre Grund für derlei Selbstsicherheit irgendwo unter den obigen Ursachen zu finden ist. Und auch wenn ich Douglas Hofstadter recht gebe (ja, es muss angenehm sein, sich seiner Sache so sicher zu sein), ziehe ich meine Zweifel dann letztlich doch vor.